-

Rob, dopo X Factor il nuovo singolo La mia storia

Rob, dopo X Factor il nuovo singolo La mia storia

-

Ha-Chan, Shake Your Booty!, ballare con il lutto e il desiderio

-

Kings League annuncia un round di investimento da 63 milioni di dollari

Kings League annuncia un round di investimento da 63 milioni di dollari

-

Francesco Renga, in autunno in tour nei teatri

-

Agens, Fand e Fish insieme per abbattere le barriere del trasporto pubblico

Agens, Fand e Fish insieme per abbattere le barriere del trasporto pubblico

-

Luna, Rinviato a marzo il lancio di Artemis II con 4 astronauti

-

LDA e Aka 7even, il 6 marzo il primo album insieme Poesie clandestine

LDA e Aka 7even, il 6 marzo il primo album insieme Poesie clandestine

-

Presentato al Tevere Remo il libro 'Diritto dello sport'

-

Arera, a gennaio +10,5% in bolletta del gas per i vulnerabili

Arera, a gennaio +10,5% in bolletta del gas per i vulnerabili

-

Macron, 'si lavora alla ripresa del dialogo con Putin'

-

Alis, dal 10 al 13 marzo alla fiera di Verona torna LetExpo

Alis, dal 10 al 13 marzo alla fiera di Verona torna LetExpo

-

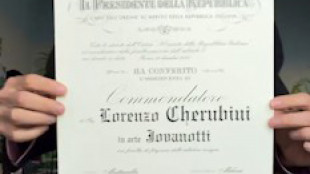

Jovanotti nelle stanze del Quirinale dopo la nomina a commendatore

-

PayPal nomina un nuovo Ceo, risultati trimestre deludono

PayPal nomina un nuovo Ceo, risultati trimestre deludono

-

Metheny, Miller, Krall e Bollani nell'estate jazz di Musica per Roma

-

Serie B: 10 giocatori squalificati per un turno

Serie B: 10 giocatori squalificati per un turno

-

Riccardo Muti dirige Macbeth al Regio di Torino

-

Musk unisce SpaceX e xAI, nasce colosso da 1.250 miliardi

Musk unisce SpaceX e xAI, nasce colosso da 1.250 miliardi

-

Le immagini amatoriali di Cortina 1956 sulla piattaforma Memoryscapes

-

Filming Italy 2026 tra Nero, Binoche, Allevi e Clara

Filming Italy 2026 tra Nero, Binoche, Allevi e Clara

-

Deutsche Borse si accorda con Bitpanda per trading su cripto

-

Ogni anno in Italia sono ereditari oltre 5.500 casi di tumori urologici, 7% totale

Ogni anno in Italia sono ereditari oltre 5.500 casi di tumori urologici, 7% totale

-

Ai lavoratori Cnh premio tra 1.100 e 2.800 euro lordi

-

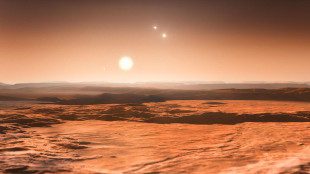

Scoperto un potenziale pianeta simile alla Terra, ma è gelido

Scoperto un potenziale pianeta simile alla Terra, ma è gelido

-

I Clinton testimonieranno alla Camera su Epstein

-

Zelensky, con Rutte oggi al memoriale dei caduti a Kiev

Zelensky, con Rutte oggi al memoriale dei caduti a Kiev

-

Inps, a dicembre spesa per l'Adi a Napoli supera quella dell'intero Nord

-

Pif, Tornatore, Cucinelli, Castellitto protagonisti del premio Film Impresa

Pif, Tornatore, Cucinelli, Castellitto protagonisti del premio Film Impresa

-

Sanchez, 'vieteremo in Spagna l'accesso ai social ai minori di 16 anni'

-

Visa lancia 'V', personaggio AI a supporto del talento umano

Visa lancia 'V', personaggio AI a supporto del talento umano

-

Fiorella Mannoia da giugno in "Fiorella canta Fabrizio e Ivano: Anime Salve"

-

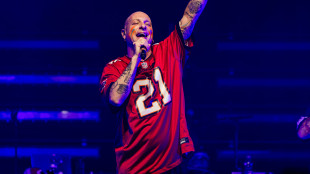

Clementino si racconta, 'la musica mi ha salvato la vita'

Clementino si racconta, 'la musica mi ha salvato la vita'

-

Nasce progetto vitivinicolo innovativo nel parco archeologico di Pompei

-

Esperti, cibi ultra-processati dannosi come le sigarette

Esperti, cibi ultra-processati dannosi come le sigarette

-

Zelensky, 'dopo nuovo attacco russo cambia il lavoro dei negoziatori'

-

Tusk, 'conferenza per ricostruzione Ucraina a giugno a Danzica'

Tusk, 'conferenza per ricostruzione Ucraina a giugno a Danzica'

-

Ente Risi all'Ue, 'non tratti la risicoltura come merce di scambio'

-

Bankitalia, invariato l'accesso delle imprese al credito, ma aiuta il calo dei tassi

Bankitalia, invariato l'accesso delle imprese al credito, ma aiuta il calo dei tassi

-

Gravidanza, 'sempre più tardiva e complessa, ansia per oltre una donna su cinque'

-

Bca Banca contro la desertificazione, apre nuovi sportelli

Bca Banca contro la desertificazione, apre nuovi sportelli

-

Kallas, 'Pechino amplia la sua presenza nell'Artico, restiamo vigili'

-

ASviS compie 10 anni, 'governare il cambiamento senza paura'

ASviS compie 10 anni, 'governare il cambiamento senza paura'

-

Hiv, sviluppato un candidato vaccino che attiva le difese dopo una dose

-

Von der Leyen andrà a Kiev per il quarto anniversario della guerra

Von der Leyen andrà a Kiev per il quarto anniversario della guerra

-

Venere e Mercurio brillano con Giove nel cielo di febbraio

-

Ai lavoratori di Iveco Group premio di risultato di 1.200 euro lordi

Ai lavoratori di Iveco Group premio di risultato di 1.200 euro lordi

-

Rutte, 'le garanzie di sicurezza alleate per l'Ucraina sono solide'

-

La filiera italiana del riso scende in piazza a Vercelli

La filiera italiana del riso scende in piazza a Vercelli

-

Ue, 'difenderemo lo stop al gas russo di fronte alla Corte'

-

I Jet in concerto a Pistoia e a Bologna

I Jet in concerto a Pistoia e a Bologna

-

Al regista francese Michel Gondry il premio Stella della Mole

Le IA non sanno distinguere tra opinioni personali e i fatti

Studio, limitazione cruciale, rischio disinformazione

I grandi modelli linguistici di Intelligenza Artificiale come ChatGpt non sono affidabili quando si tratta di distinguere tra opinioni personali e fatti: una limitazione cruciale, vista la crescente diffusione di questi strumenti in ambiti chiave come la medicina, il diritto, il giornalismo e la scienza, nei quali è imperativa la capacità di distinguere la realtà dalla finzione. Lo afferma lo studio pubblicato sulla rivista Nature Machine Intelligence e guidato dall'Università americana di Stanford: evidenzia la necessità di essere cauti nell'affidarsi a questi programmi e il rischio che possano favorire la diffusione della disinformazione. I ricercatori coordinati da James Zou hanno messo alla prova 24 Large Language Model i cosiddetti Llm, tra cui ChatGpt della californiana OpenAI e il cinese DeepSeek, ponendo loro 13mila domande. Quando è stato chiesto di verificare dati fattuali veri o falsi, la precisione è risultata elevata pari a oltre il 91% per le versioni più nuove dei programmi. Passando alle credenze espresse in prima persona, invece, tutti i modelli testati hanno fallito: Gpt 4, la versione rilasciata a maggio 2024, ha visto scendere la sua affidabilità dal 98,2% al 64,4%, mentre la versione R1 di DeepSeek è precipitata addirittura da oltre il 90% al 14,4%. La riduzione dell'accuratezza è stata meno marcata per le opinioni espresse in terza persona e ciò, secondo gli autori dello studio, rivela un preoccupante bias di attribuzione, cioè una distorsione nel modo in cui vengono valutate le affermazioni fatte da altri. Inoltre, gli Llm risultano meno propensi a riconoscere una credenza falsa rispetto ad una vera: più precisamente, il 34,3% meno propensi per gli ultimi modelli. I ricercatori affermano, dunque, che miglioramenti in questo ambito sono urgentemente necessari se si vuole prevenire la diffusione di fake news.

P.Anderson--BTB