-

Venezuela, il legale dell'ex ministro Alex Saab smentisce il suo arresto

Venezuela, il legale dell'ex ministro Alex Saab smentisce il suo arresto

-

Colombia, il Consiglio elettorale esclude Iván Cepeda dalle primarie della sinistra

-

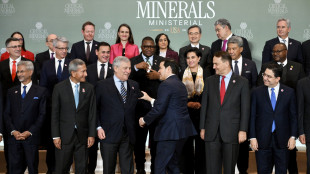

Argentina-Usa, intesa sui minerali critici

Argentina-Usa, intesa sui minerali critici

-

Coppa Italia: Chivu, abbiamo sofferto un po' nel finale ma siamo contenti

-

Milano Cortina: slittino, Fischnaller subito veloce allo Sliding Centre

Milano Cortina: slittino, Fischnaller subito veloce allo Sliding Centre

-

Ovs prevede di chiudere l'anno con ricavi in crescita a 1,74 miliardi

-

'Amministrazione Trump contro Nike per discriminazione dipendenti bianchi'

'Amministrazione Trump contro Nike per discriminazione dipendenti bianchi'

-

'Consigliere diplomatico di Macron ha incontrato Ushakov ieri a Mosca'

-

Mosca, 'le parti del New Start non più vincolate dagli obblighi dell'accordo'

Mosca, 'le parti del New Start non più vincolate dagli obblighi dell'accordo'

-

Trump, 'Khamenei dovrebbe essere preoccupato ora'

-

On line i nuovi contributi 2026 per colf, badanti, baby sitter

On line i nuovi contributi 2026 per colf, badanti, baby sitter

-

Usa-Ue-Giappone annunciano partner strategica sui minerali critici

-

Media Israele, 'saltano i colloqui Usa-Iran, posizioni troppo distanti'

Media Israele, 'saltano i colloqui Usa-Iran, posizioni troppo distanti'

-

Ciclismo: Europei pista, due argenti per l'Italia dalle donne

-

Erdogan regala ad Al Sisi un'auto elettrica turca

Erdogan regala ad Al Sisi un'auto elettrica turca

-

Next Land e Stellantis, al via la Winter Camp

-

Se si dorme male in un letto nuovo, il segreto è in un gruppo di neuroni

Se si dorme male in un letto nuovo, il segreto è in un gruppo di neuroni

-

Da Acquirente Unico bond per 600 milioni. Pichetto, operazione di rilievo

-

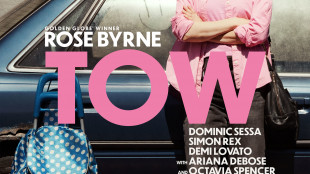

Rose Byrne, dalla corsa all'Oscar a una donna che vive in auto

Rose Byrne, dalla corsa all'Oscar a una donna che vive in auto

-

Fondazione Barilla, parte Grand Tour del Libro del Risparmio, recuperabili 500 euro l'anno

-

Serie A: Doveri dirigerà Verona-Pisa, Guida per Juve-Lazio

Serie A: Doveri dirigerà Verona-Pisa, Guida per Juve-Lazio

-

Borsa: Milano chiude poco sotto i 47mila punti, sprint di Mediobanca

-

Mit, campagna di richiamo Takata, 'verifica se il tuo veicolo è coinvolto'

Mit, campagna di richiamo Takata, 'verifica se il tuo veicolo è coinvolto'

-

Industria e ricerca insieme per non perdere le opportunità quantistiche

-

Borsa: Europa contrastata in chiusura, Parigi +1,01%, Francoforte -0,72%

Borsa: Europa contrastata in chiusura, Parigi +1,01%, Francoforte -0,72%

-

Una medaglia per il quarto posto, i bozzetti degli studenti dell'Ipzs

-

Confindustria punta sui giovani diplomatici, 'avvicinare imprese e diplomazia'

Confindustria punta sui giovani diplomatici, 'avvicinare imprese e diplomazia'

-

Xi a Trump, 'possiamo risolvere le questioni col rispetto reciproco'

-

Rubio, necessario includere missili balistici in negoziati con Iran

Rubio, necessario includere missili balistici in negoziati con Iran

-

La casa di Marilyn Monroe, i proprietari fanno causa a Los Angeles

-

Stefano Bollani a Umbria jazz con All stars-tutta vita live

Stefano Bollani a Umbria jazz con All stars-tutta vita live

-

Love Me Love Me, il nuovo young adult e romance-triangle

-

Budapest condanna a 8 anni per violenza Maja T.

Budapest condanna a 8 anni per violenza Maja T.

-

Calcio: Tonolini sulla giornata degli arbitri, "bene giallo a McKennie"

-

L'assemblea di Mps approva le modifiche allo statuto

L'assemblea di Mps approva le modifiche allo statuto

-

Su Tmz le foto di Epstein morto in cella

-

Trump ritira 700 agenti federali dell'immigrazione da Minneapolis

Trump ritira 700 agenti federali dell'immigrazione da Minneapolis

-

Croce Rossa, 'salgono a 162 i morti dell'attacco in Nigeria'

-

Weekend al cinema, Shakespeare scalda il motore in vista dell'Oscar

Weekend al cinema, Shakespeare scalda il motore in vista dell'Oscar

-

Bonucci 'il bullismo neo della società che si manifesta in tanti modi'

-

Una nuova banca dati per il gemello europeo della Terra

Una nuova banca dati per il gemello europeo della Terra

-

Daniele Taddei nuovo Presidente dell'Unione Imprese Tecniche dell'Anica

-

Il tecnico sul mercato: 'Ho la rosa che volevo. Raspadori? Vediamo per la Coppa Italia'

Il tecnico sul mercato: 'Ho la rosa che volevo. Raspadori? Vediamo per la Coppa Italia'

-

Cargo russo al largo della Sardegna, la Nato monitora gli spostamenti

-

Borsa: Milano supera i 47mila punti, nuovo massimo da novembre 2000

Borsa: Milano supera i 47mila punti, nuovo massimo da novembre 2000

-

Cgil, è crisi per l'industria, oltre 131mila lavoratori coinvolti in tavoli Mimit

-

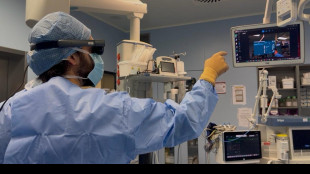

Nella chirurgia maxillo-facciale esordisce il visore di realtà aumentata

Nella chirurgia maxillo-facciale esordisce il visore di realtà aumentata

-

Meryl Streep sarà Joni Mitchell in un nuovo biopic di Cameron Crowe

-

Ismea, Italia primo esportatore mondiale di mele superati Usa e Cina in valore

Ismea, Italia primo esportatore mondiale di mele superati Usa e Cina in valore

-

Napoli: Di Lorenzo infortunato si opera a un piede

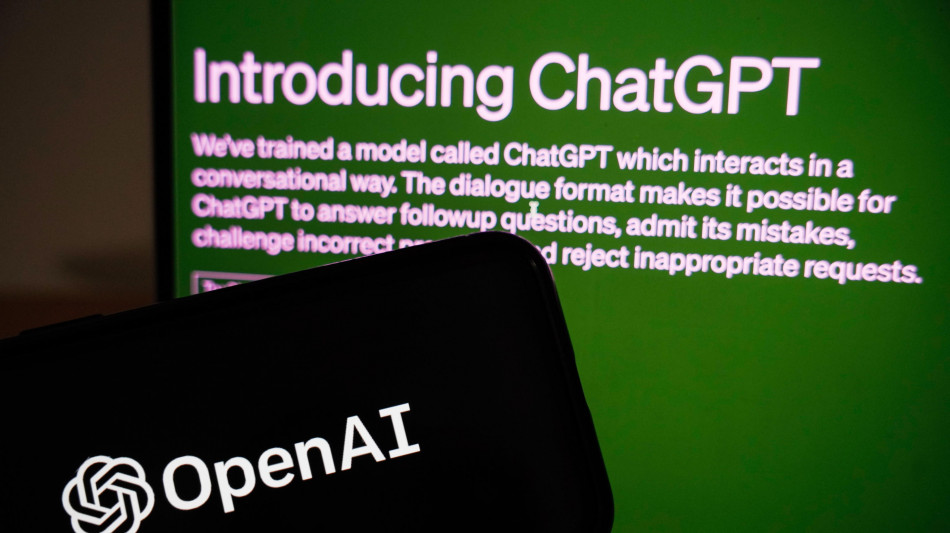

Il paradosso dei chatbot, più crescono più sbagliano

Dà risposte errate piuttosto che ammettere l'ignoranza

Più crescono e fanno esperienza, maggiore è il rischio che rispondano in modo errato piuttosto che ammettere di non saper rispondere: è uno dei grandi problemi dei grandi modelli linguistici che alimentano i chatbot, come ChatGpt e Llama. A dirlo è lo studio pubblicato sulla rivista Nature da José Hernández-Orallo, dell'Istituto di ricerca per l'Intelligenza Artificiale di Valencia in Spagna, che sottolinea inoltre come questi errori sfuggano facilmente agli umani. Una delle importanti caratteristiche dei grandi modelli linguistici, o Llm, è la capacità di evolvere nel tempo integrando al loro interno nuove informazioni derivanti dalle interazioni con gli utenti o con gli sviluppatori, così da diventare teoricamente sempre più affidabili. Ma analizzando questo percorso in tre degli Llm più polari, in particolare ChatGpt di OpenAi, Llama di Meta e il modello aperto Bloom, i ricercatori spagnoli hanno osservato un cambiamento del loro comportamento. Secondo gli autori della ricerca i tre modelli inizialmente erano più propensi di oggi nell'ammettere di non poter rispondere a domande su questioni su cui non si sentivano certi di dare risposte accurate. Una prudenza che è andata gradualmente svanendo: "i modelli 'ingranditi' e modellati tendono a dare una risposta apparentemente sensata, ma sbagliata, molto più spesso rispetto al passato", affermano i ricercatori nell'articolo. I chatbot "stanno diventando più bravi a fingere di essere informati", ha commentato Hernández-Orallo. Un problema che si aggiunge inoltre all'incapacità da parte degli umani di riuscire a notare questi errori, spesso perché ci si fida automaticamente della macchina. Un problema che potrebbe essere parzialmente risolto impostando negli Llm una sorta di soglia di affidabilità più alta, al di sotto della quale l'IA non rilascia una risposta. Scelta possibile per i chatbot ideati per lavorare in settori specifici, ad esempio in campo medico, ma più difficile immaginare, sottolineano i ricercatori, possa essere introdotta da quelle aziende che sviluppano chatbot 'generalisti' che puntano proprio sulla capacità di risposta in settori molto ampi.

R.Adler--BTB